OpenAI desmantela el equipo de Superalineación

No es raro que BigTech despida a equipos enteros de ética y alineación de la IA. OpenAI también está haciendo gestión de costes.

Es domingo pero hay problemas en el paraíso de OpenAI. Con un importante éxodo de talentos, especialmente en el bando que no apoya a Sam Altman. La historia reciente de OpenAI daría para un documental sobre una startup bastante decente.

Con la salida de Ilya Sutskever y Jan Leike de OpenAI, su equipo de Superalineación, creado en julio de 2023, hace menos de un año, ha quedado completamente desmantelado.

No está claro qué dice esto sobre el compromiso de OpenAI y Microsoft con la confianza y la seguridad de la IA. Sin embargo, esto no es inusual, es habitual. En marzo de 2023, Microsoft despidió a todo su equipo de ética y sociedad.

El movimiento pone en duda las afirmaciones de OpenAI sobre la AGI

Si la AGI es una narrativa real, ¿por qué haría esto OpenAI? O bien la realidad está muy lejos de la AGI, o bien las empresas comerciales de modelo cerrado no tienen incentivos para priorizar realmente la confianza y la seguridad de la IA y el desarrollo y la gobernanza responsables de la IA. En marzo de 2024, Google también despidió a gente de su equipo de confianza y seguridad. Está claro que no se consideran puestos de alta prioridad.

El 17 de mayo de 2024, OpenAI disolvió por completo su equipo centrado en los riesgos a largo plazo de la inteligencia artificial.

Dos miembros del equipo de Superalignemnt también fueron despedidos por filtraciones.

La parte de OpenAI que debía salvaguardar a la humanidad no recibía los recursos informáticos que pedía para hacer su trabajo. De hecho, ni siquiera recibían una fracción de ellos. La idea de que Jan e Ilya han "dimitido" es un poco hipócrita, ni siquiera eran capaces de hacer bien su trabajo. A menudo se denegaban las solicitudes de una fracción de ese cómputo, lo que impedía al equipo hacer su trabajo.

La AGI y el marketing del riesgo existencial

Según OpenAI, AGI es un término utilizado para referirse a una forma de inteligencia artificial que puede completar tareas al mismo nivel, o un paso por encima, de los humanos. ¿El problema? Eso no es lo que la AGI es en realidad. La AGI es un sistema capaz de aprender de forma generalizada, que es sintiente con autodeterminación para evolucionar en sus propios términos. Esta versión comercial de bajo grado de AGI, una herramienta AGI con implicaciones comerciales, también es una construcción dudosa.

La idea de que la AGI está en el horizonte o de que la IA es un riesgo existencial a corto plazo, debido a que se convertiría en superinteligente, son probablemente fabricaciones y tipos de fraude. Pero también se trata de una dicotomía que hizo que la gente hablara (una especie de crecimiento del sentimiento subliminal) sobre la IA Generativa y el bombo que OpenAI intentó (y sigue intentando) defender. Sin embargo, el hecho de que un complejo industrial de medios sociales repita como un loro estas cosas no lo convierte en algo real.

El cofundador de OpenAI, Ilya Sutskever, y Jan Leike, anunciaron su salida de la startup respaldada por Microsoft la semana pasada, lo que arroja algo de sombra sobre la credibilidad de OpenAI. El equipo de Superalineación de OpenAI, anunciado en 2023, ha estado trabajando para lograr "avances científicos y técnicos para dirigir y controlar sistemas de IA mucho más inteligentes que nosotros". ¿Cualesquiera que sean?

Jan Leike, en el Taller de Cooperación Inteligente 2023 de Foresight.

En X (antes Twitter), Leike hizo públicas algunas de las razones de su dimisión el viernes por la mañana. "He estado en desacuerdo con la dirección de OpenAI sobre las principales prioridades de la empresa durante bastante tiempo, hasta que finalmente hemos llegado a un punto de ruptura", escribió Leike en una serie de mensajes en X. "Creo que deberíamos dedicar mucho más tiempo a prepararnos para las próximas generaciones de modelos, en seguridad, supervisión, preparación, seguridad, solidez frente a adversarios, (super)alineación, confidencialidad, impacto social y temas relacionados. Estos problemas son bastante difíciles de resolver, y me preocupa que no estemos en la trayectoria adecuada para conseguirlo".

En el verano de 2023, OpenAI dijo que dedicaría el 20% de su potencia informática a la iniciativa durante cuatro años. Así que, obviamente, con el regreso de Sam Altman al puesto de director general y el cambio de la junta directiva, eso nunca ocurrió.

La importancia de la marcha de Ilya y este fin del equipo de Superalignemnt, también dice mucho sobre la dirección comercial que está tomando OpenAI y sobre quién controla realmente la startup ahora. Cuando aceptas 13.000 millones de dólares y la computación Azure de Microsoft, renuncias a gran parte de tu libertad como startup. Decir que OpenAI ha comprometido su misión, su ética y su condición de organización sin ánimo de lucro, sería quedarse corto.

Este giro dramático también pone en tela de juicio todo el movimiento de alineación y seguridad de la IA. En términos de talento, durante meses hemos sido testigos de que OpenAI ha ido perdiendo empleados que se preocupan profundamente por garantizar que la IA sea segura. Ahora, a mediados de 2024, la empresa está sufriendo una hemorragia de ellos. ¿Qué debemos pensar de todo esto?

OpenAI despojada de Ilya y de la gente que le respaldó y sin un equipo, un producto y una arquitectura Superalignemnt, no es más que una sombra de lo que fue para algunas personas. Incluso cuando ChatGPT aún no ha alcanzado una escala crítica, con sólo unos 100 millones de supuestos usuarios. Ahora gana más con ChatGPT Enterprise y las ventas B2B que directamente al consumidor. Después de la próxima financiación masiva de xAI, OpenAI tendrá que conseguir aún más financiación y quizá incluso acelerar el camino hacia una salida a bolsa.

Desde el punto de vista empresarial, Sam Altman no puede permitirse que haya facciones dentro de su comunidad. No puede permitirse tener aún más dramas, después de todos los dramas que en parte se han causado durante su mandato de liderazgo. Básicamente, es lo que cabría esperar en una startup de IA que está aumentando sus ingresos a este ritmo extraordinario, un ejemplo para todo el movimiento de la IA Generativa 18 meses después de que se anunciara ChatGPT.

A finales de enero de 2024, Google dividió un equipo clave de vigilancia ética en sus equipos internos. El pequeño equipo había servido como su principal vigilante ético interno de la IA. Lo que podemos deducir es que Microsoft, Google y OpenAI consideran que la ética, la alineación y la confianza y la seguridad de la IA son totalmente prescindibles, especialmente cuando observan algo en el negocio que puede contradecir la imagen, las relaciones públicas y la postura de marketing de la empresa.

Esto sugiere que no podemos confiar en que los líderes de la IA a hiperescala tengan los incentivos adecuados para gestionar internamente la alineación de la IA de forma responsable. Por supuesto, esto no es del todo chocante.

Hace poco se nos dijo que la superinteligencia tiene el potencial de ser el avance tecnológico más importante de la historia de la humanidad. Si eso es cierto, ¿no sería la seguridad y la alineación una idea bastante buena?

Aunque la superinteligencia pueda parecer lejana, muchos expertos parecen creer que podría hacerse realidad en los próximos años. ¿Es eso cierto?

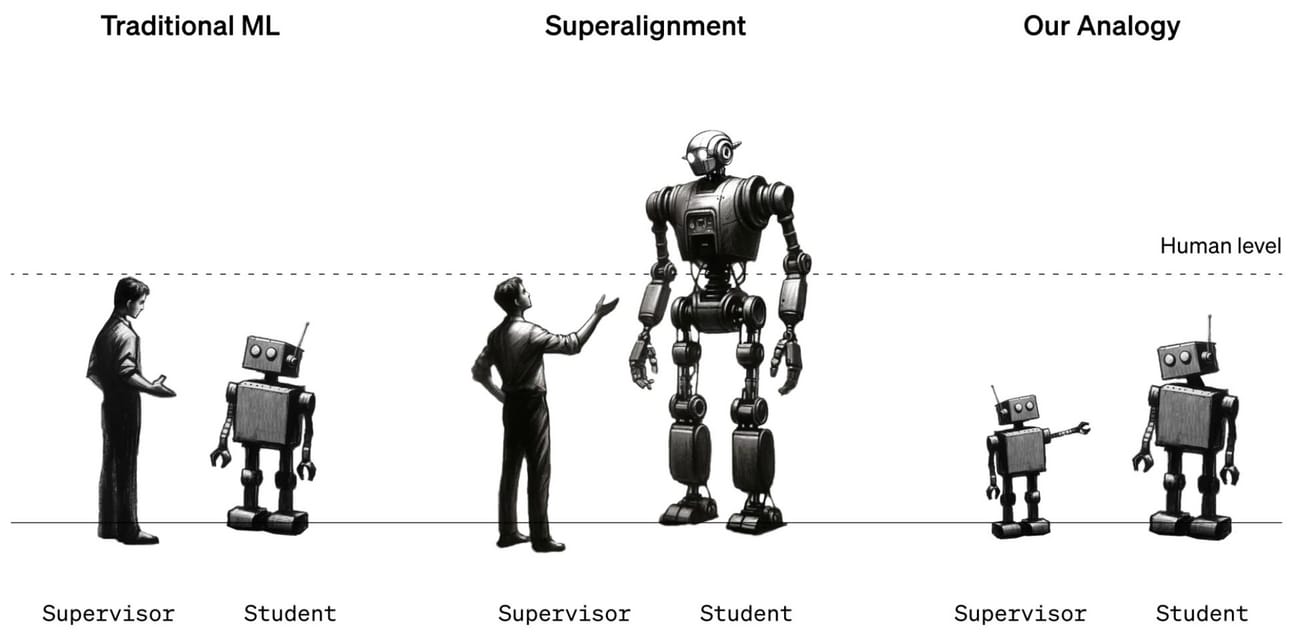

Qué es la superalineación

La superalineación se refiere a garantizar que los sistemas de superinteligencia artificial (IA), que superan a la inteligencia humana en todos los ámbitos, actúen de acuerdo con los valores y objetivos humanos. Es un concepto esencial en el campo de la seguridad y la gobernanza de la IA, cuyo objetivo es abordar los riesgos asociados al desarrollo y despliegue de IA muy avanzada.

¿Habría sido capaz OpenAI de resolver los principales retos técnicos del control de la IA superinteligente en los próximos cuatro años, tal y como afirmó este equipo? Según los rumores, y no puedo comentar la base fáctica de lo siguiente:

"La Superalineación desempeña un papel crucial a la hora de abordar los riesgos potenciales asociados a la superinteligencia. Entonces, ¿para qué necesitaría la civilización la Superalineación en primer lugar?

Mitigar los Escenarios de IA Canalla: La superalineación garantiza que los sistemas de IA superinteligentes se alineen con la intención humana, reduciendo los riesgos de comportamiento incontrolado y daño potencial.

Salvaguardar los valores humanos: Al alinear los sistemas de IA con los valores humanos, la Superalineación evita los conflictos en los que la IA superinteligente puede dar prioridad a objetivos incongruentes con las normas y principios sociales.

Evitar consecuencias imprevistas: La investigación de la Superalineación identifica y mitiga los resultados adversos no intencionados que pueden surgir de los sistemas avanzados de IA, minimizando los posibles efectos adversos.

Garantizar la autonomía humana: La Superalineación se centra en el diseño de sistemas de IA como herramientas valiosas que aumentan las capacidades humanas, preservando nuestra autonomía y evitando la dependencia excesiva de la toma de decisiones de la IA.

Construir un futuro beneficioso para la IA: La investigación de la Superalineación pretende crear un futuro en el que los sistemas de IA superinteligentes contribuyan positivamente al bienestar humano, abordando los retos globales y minimizando los riesgos.

Mientras tanto, no estoy seguro de dónde pueden encontrar trabajo estable todos estos expertos en políticas de gobernanza de la IA e investigadores serios de Superalignemnt, ¿y tú? Quizá en empresas como Anthorpic y en organizaciones sin ánimo de lucro legales. Mientras se les permita seguir existiendo.

A pesar de toda la hipocresía y los obvios trucos de marketing, OpenAI sigue teniendo un amplio abanico de evangelistas y entusiastas a sueldo que esgrimen los argumentos habituales y las afirmaciones extravagantes, una y otra vez. Mientras la mayoría de los consumidores de a pie confían cada vez menos en la IA con cada mes que pasa, continúa el bombo de la IA Generativa y el FOMO Corporativo, y aquellos que, como yo, luchan incluso por encontrar una utilidad básica de los agentes y sus capacidades en nuestras vidas.

Con un supuesto avance y proliferación de agentes de IA, estoy observando sobre todo una variedad de chatbots y copilotos que aportan un valor discutible a los consumidores o a los entornos empresariales. La burbuja de la IA Generativa seguramente continuará a medida que nos acerquemos a los resultados de Nvidia. ¿Pero cuánto tiempo más puede continuar la burbuja de la IA? ¿A pesar del marketing de OpenAI o de la presión de los intereses propios del capital riesgo impulsados por el optimismo tecnológico?

La demanda de chips de IA sigue siendo alta en 2024, pero la de Superalineación, no tanto.

Se suponía que OpenAI estaba construyendo un investigador de alineación automatizada de nivel humano que utilizaría grandes cantidades de computación para escalar los esfuerzos y alinear iterativamente la superinteligencia. En retrospectiva, esto parece haber resultado ser más una promesa vacía que algo serio.

El equipo de Superalineación consiguió publicar un corpus de investigación sobre seguridad y canalizar millones de dólares en subvenciones a investigadores externos. Así pues, ¿cuál es la gran valoración de la prioridad de la alineación de la IA en la mayor empresa de investigación sobre IA del mundo? Leike, que acaba de dimitir esta semana, dijo: "Pero en los últimos años, la cultura y los procesos de seguridad han pasado a un segundo plano frente a los productos brillantes".

Sam Altman y Microsoft han llevado claramente a OpenAI en una nueva y valiente dirección. Una en la que el mayor valor es la generación de ingresos y no la investigación en IA. La pérdida del equipo de Superalineación en las startups de IA Generativa mejor financiadas envía un mensaje más amplio al ecosistema: La confianza, la seguridad de la IA, la IA responsable y la alineación no son una prioridad. Las respuestas de BigTech a estas medidas siempre parecen medidas provisionales.

Mientras tanto, Google anunció ayer su Red de Seguridad Fronteriza. Jennifer Beroshi dijo en LinkedIn:

"No vemos ninguna contradicción entre abordar los riesgos actuales de la IA y prepararse para los riesgos futuros. Aunque los modelos actuales no presentan estos riesgos, ahora es el momento de construir la infraestructura de seguridad adecuada."

En una era de IA Generativa que coincide con un crecimiento más lento de las Ganancias, incluso las empresas de hiperescala están practicando un fino equilibrio entre la gestión de costes y la evaluación de riesgos.

Google, Meta, OpenAI y Microsoft se apresuran a intentar mitigar las preocupaciones sobre la IA. El documento publicado el viernes por Google DeepMind describe un proceso en el que los modelos de DeepMind se reevaluarán cada vez que la potencia de cálculo utilizada para entrenar el modelo se multiplique por seis, o se afine durante tres meses. En el tiempo entre evaluaciones, dice que diseñará evaluaciones de alerta temprana.

Pero, ¿podemos realmente confiar la seguridad de la IA a BigTech?

Hasta la proxima 🔥🔥